GoTo AI Trust Center

Zuletzt geändert am: 3. März 2025

Einführung

GoTo gibt seinen Kunden Werkzeuge an die Hand, mit denen sie ihre Produktivität und Effizienz steigern können, indem Künstliche-Intelligenz(KI)-Dienste in unsere Produkte für Geschäftskommunikation, Zusammenarbeit, Remotesupport und IT-Management („GoTo-Dienste“) integriert werden.

Wir verwenden Large Language Models (LLMs) und grundlegende KI-Modelle, um eine wachsende Zahl von Anwendungsfällen in unseren GoTo-Diensten zu unterstützen, z. B. interaktive KI-basierte Assistenten, Vorschläge zur IT-Fehlerbehebung, Erstellung und Analyse von Skripten für das IT-Management, Zusammenfassung von Meetings und Calls und Bereitstellung von Einblicken in das operative Geschäft.

Die KI bietet zwar erhebliche Vorteile, ist aber auch eine sich schnell weiterentwickelnde Technologie, die potenzielle Risiken birgt. Auf dieser Seite erläutern wir den GoTo-Ansatz für sichere Entwicklungspraktiken, der darauf abzielt, diese Risiken zu bewältigen und unseren Kunden dabei zu helfen, von KI-basierten Features und Funktionalitäten zu profitieren.

Datenschutz und Sicherheit stehen an erster Stelle, wenn GoTo eine KI-Funktion entwirft. Für weitere Informationen über die Datenschutz- und Sicherheitsprogramme von GoTo besuchen Sie bitte unser Trust Center.

Verantwortliche Nutzung von KI bei GoTo

GoTo verpflichtet sich, künstliche Intelligenz verantwortungsvoll einzusetzen, um Produktfunktionen bereitzustellen, die die Effizienz fördern, und gleichzeitig Maßnahmen zum Schutz vor unethischen oder anderweitig schädlichen Ergebnissen zu ergreifen. Bei der Entwicklung unserer KI-fähigen Produktfunktionen haben wir daher die Grundsätze einer verantwortungsvollen KI im Blick:

- Fairness. Schutz vor voreingenommenen oder diskriminierenden Ausgaben, einschließlich durch Verringern der Nutzung von Dateneingaben, die zu diskriminierendem Modellverhalten führen können, auf ein Minimum.

- Transparenz. Kunden und Benutzer wissen, dass sie mit KI interagieren und KI-gestützte Funktionen nutzen. GoTo erklärt, wie und wo KI in Produkte eingebaut ist und wie sie funktioniert.

- Rechenschaftspflicht. Es werden Überwachungs- und Prüfmechanismen zur Erkennung von unerwarteten oder schädlichen Ausgaben implementiert. Die Funktionen sind so konzipiert, dass sie eine menschliche Beaufsichtigung und Kontrolle ermöglichen, die den Risiken und der Art der KI-fähigen Funktion angemessen ist.

- Datenschutz und Sicherheit. GoTo implementiert robuste Systemdesigns mit regelmäßigen Tests und Monitoring, um Daten zu schützen. Datenschutz durch Technikgestaltung (Privacy by Design) wird in das Design von KI-aktivierten Funktionen integriert, sodass diese nur das Mindestmaß an Daten verarbeiten, das zur Erfüllung ihres Zwecks erforderlich ist.

- Ethisch einwandfreie Verwendung. KI wird für positive und nicht schädliche Zwecke eingesetzt. Kontrollen zum Schutz vor KI-Halluzinationen, Fehlinformationen, Ungenauigkeiten, Menschenrechtsverletzungen und anderen potenziell schädlichen Ausgaben sind vorhanden.

Leitgedanke: Unser KI-Vertrauensmodell

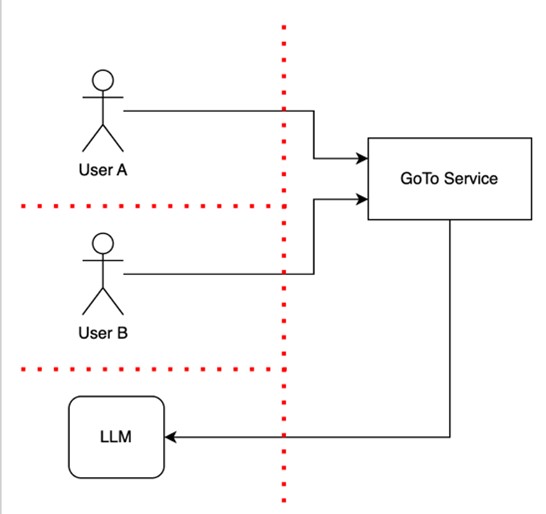

Der Ansatz von GoTo bei der Entwicklung von KI-Funktionen beinhaltet die Einführung von Vertrauensbarrieren, um die Daten der Benutzer voneinander sowie von der Produktinfrastruktur zu trennen. Das Vertrauensmodell berücksichtigt, dass eine vertrauenswürdige Infrastruktur weder Menschen noch KI-Modelle in dieselbe Vertrauens-Enklave aufnehmen kann, und wird im folgenden Diagramm dargestellt.

Das Diagramm zeigt zwei Benutzer, Benutzer A und Benutzer B. Beide verwenden einen GoTo-Dienst mit einer LLM-basierten Funktion, die durch den Pfeil zu einem LLM angezeigt wird. Die rote Linie stellt Vertrauensbarrieren dar, die gesichert sind, um sensible Daten und Funktionen zu schützen sowie um Benutzer voneinander und von der Produktinfrastruktur, einschließlich dem LLM, zu trennen. Diese Vertrauensbarrieren ermöglichen Vertrauensprüfungen (z. B. Authentifizierung, Autorisierung und Plausibilitätskontrollen), wenn sie von Kontroll- oder Datenströme durchquert werden.

Wie dieses Diagramm zeigt, hat Benutzer B keinen Zugriff auf die Daten oder Geräte von Benutzer A.

Dieses Vertrauensmodell trägt dazu bei, Kundendaten vor unbefugtem Zugriff oder unbefugter Nutzung zu schützen und die GoTo-Dienste vor Angriffen oder Schwachstellen zu bewahren.

Schutzmechanismen

Bei der Entwicklung von LLM-Anwendungen oder LLM-basierten Funktionen hält sich GoTo über LLM-spezifische und andere KI-bezogene Risiken wie Prompt Injection, Training Data Poisoning und Schwachstellen in der Lieferkette auf dem Laufenden und führt Schutzmaßnahmen ein, um diese zu adressieren. Unter Berücksichtigung des GoTo-Vertrauensmodells und der allgemeinen KI-bezogenen Risiken setzen wir mehrere Mechanismen ein, die im Folgenden näher erläutert werden. Dazu gehören u. a. auch menschliche Kontrollen und die Mandantenfähigkeit, die unseren Benutzern dabei helfen sollen, KI-Anwendungen und -Funktionen in einer Weise zu nutzen, die die Datensicherheit fördert.

KI-Modelle bieten wertvolle Mechanismen zur Automatisierung von Aufgaben, zur Generierung von Antworten auf Abfragen und zur Erstellung verschiedener Artefakte. Benutzer müssen sich aber auch bewusst sein, dass sich diese Modelle dadurch von herkömmlichen Softwarediensten unterscheiden, dass sie falsche Antworten oder unbeabsichtigte Ausgaben produzieren können. Wenn Sie KI-basierte Anwendungen verwenden, sollten Sie den Ausgaben von KI-Modellen (einschließlich LLMs) in ähnlichem Maße vertrauen wie Ausgaben, die von anderen Benutzern erstellt wurden. Kurz gesagt heißt das: Vertrauen, aber überprüfen. Sie sollten als Reaktion auf Ihre Benutzeranfragen immer die Vollständigkeit und Genauigkeit der KI-Ausgaben überprüfen.

Unter Berücksichtigung dessen werden gegebenenfalls die folgenden Schutzmechanismen implementiert, wenn KI in GoTo-Dienste integriert wird:

- Menschliche Kontrolle. KI-fähige Funktionen sind so konzipiert, dass der Benutzer das letzte Wort darüber hat, ob und wie die von einem KI-Modell (z. B. einem LLM) erzeugte Ausgabe verwendet wird. Benutzer, die Produkte verwenden, behalten die Kontrolle, und sensible Maßnahmen müssen von einem Menschen genehmigt werden.

- Mandantenfähigkeit mit LLM. GoTo sorgt dafür, dass einzelne Benutzer separate Sitzungen (Unterhaltungen) mit dem LLM-Dienst führen, die für andere Benutzer nicht zugänglich sind. Das bedeutet, dass andere Benutzer nicht auf sensible Informationen zugreifen können, die versehentlich in einer Eingabeaufforderung freigegeben wurden.

- Kundendaten werden nicht von Dritten zum Trainieren ihrer LLM-Dienste verwendet. Bei der Bereitstellung von KI-fähigen Funktionen durch einen Drittanbieter ist es Drittanbietern untersagt, die Daten von GoTo-Kunden für Trainingszwecke zu verwenden.

- Validierung von Eingaben und Ausgaben. Die GoTo-Dienste validieren das Format von Eingaben anhand gängiger Validierungstechniken, einschließlich regulärer Ausdrücke und Parser. Unsere Dienste weisen bestimmte Arten unerwarteter Ein- und Ausgaben basierend auf den Validierungsergebnissen zurück, um Sicherheitsrisiken zu verringern, Datenverlust oder -beschädigung zu verhindern und Fehler zu minimieren. Wir validieren zum Beispiel, ob es sich bei unerwarteten Ein- und Ausgaben um Textinjektionen, irrelevante Eingabeaufforderungen, beschädigte Daten oder ungezwungene Fehlerfälle handelt.

Transparenz: Nutzung von KI-Funktionen

Wir bemühen uns, die KI-fähigen Funktionen in GoTo-Diensten klar zu kennzeichnen. Zum Beispiel kennzeichnen wir Funktionen, die KI nutzen, durch Text oder ein funkelndes Symbol, wie unten gezeigt. Unsere Kunden können frei entscheiden, ob sie die Funktion oder die daraus resultierende Ausgabe nutzen möchten oder nicht. In einigen Fällen können Kunden oder Benutzer sich zur Deaktivierung von KI-fähigen Funktionen, die sie nicht nutzen möchten, entschließen. Weitere Informationen erhalten Sie auf den produktspezifischen Supportseiten.

Beispiele für die Identifizierung von KI-Merkmalen:

Transparenz: Verwendung von Daten

In begrenzten Fällen und nur dann, wenn die Kunden bezüglich dieser Verwendung eine Wahl haben, darf GoTo Kundendaten verwenden, um die KI-Modelle von GoTo zu trainieren und so die allgemeine Ausgabequalität eines Produkts zu verbessern. Für Kunden, die dieser Verwendung von Daten zustimmen, ergreift GoTo Maßnahmen, um nur die benötigten Informationen zu verarbeiten und LLM-Anfragen auf die wesentlichen kontextbezogenen Details zu beschränken, wie weiter unten im Abschnitt „Datenminimierung“ erläutert. Ein Beispiel für diesen Ansatz finden Sie im FAQ zur Verwendung der Inhalte von LogMeIn Resolve-Benutzern.

Weitere Informationen über die Nutzung von KI-fähigen Funktionen in GoTo-Produkten finden Sie in den GoTo KI-Bedingungen, die für die Nutzung dieser Funktionen durch einen Kunden gelten.

Datenminimierung

GoTo versucht, LLM-Anfragen auf die wesentlichen kontextbezogenen Details zu beschränken. Wenn ein Kunde beispielsweise kontextbezogene Details in eine LLM-Eingabe aufnehmen möchte, um die Genauigkeit zu verbessern, versuchen die GoTo-Dienste anhand einer Technik namens Retrieval Augmented Generation (RAG), nur Informationen zu nutzen, die im Kontext relevant sind. Bei der Diagnose eines Geräts in LogMeIn Resolve oder Rescue beziehen wir beispielsweise Gerätedaten wie CPU und Arbeitsspeicher mit ein, vermeiden es aber, persönliche Daten über die Benutzer des Geräts weiterzugeben.

Least Privilege und funktionsbasiertes Risiko

Bei der Entwicklung von GoTo-Diensten, einschließlich KI-fähigen Funktionen, verfolgen wir einen risikobasierten Ansatz und dem Least-Privilege-Prinzip, was bedeutet, dass ein KI-Dienst nur auf diejenigen spezifischen Daten oder Ressourcen zugreifen kann, die erforderlich sind (d. h. wir schränken den Datenzugriff technisch ein, beispielsweise durch technische Rollen mit eng gefassten Zugriffsrechten).

Bevor wir uns für die Implementierung einer KI-gestützten Funktion entscheiden, erwägen wir die Risiken der Funktion. Um den Zugriff angemessen einzuschränken, beschränken wir die Privilegien und Daten, auf die ein KI-Dienst zugreifen kann, auf das für das Funktionieren der Funktion erforderliche Maß.